A mí o a tus propios ojos

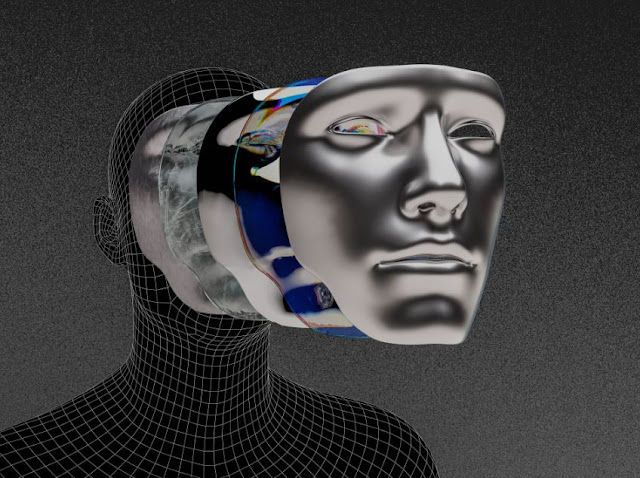

Se denomina deepfake a una técnica basada en inteligencia artificial que permite generar vídeos falsos de personas aparentemente reales, partiendo de imágenes y grabaciones verídicas ya existentes, mediante la aplicación de algoritmos de aprendizaje no supervisados, conocidos en castellano por las siglas RGA (Red Generativa Antagónica). Como resultado de este proceso, se obtienen secuencias increíblemente verosímiles pero ficticias, por ejemplo, de celebridades haciendo o diciendo cosas que no han hecho o dicho jamás. Todo esto nos puede sonar a chino, pero ya lo hemos visto con nuestros propios ojos, de forma consciente o inconsciente.

Pensemos, por ejemplo, en el conocido spot televisivo de la cerveza Cruzcampo, protagonizado por la desaparecida Lola Flores: “Con mucho acento”. La folclórica jamás pronunció las frases que vemos en este anuncio, que en realidad fue interpretado por una actriz. Para lograr el resultado final, fue necesario rescatar horas y horas de grabaciones de la Faraona, y combinarlas con más de 5.000 fotografías de la cantante jerezana. Pese a que sus dos hijas participaron en la campaña y dieron permiso expreso para realizarla, han sido numerosas las voces que han cuestionado éticamente la utilización de la imagen de una persona fallecida, haciéndole decir lo que nunca dijo, por muy inocente que sea. Algo parecido sucedió en el Dalí Museum de Florida, cuando la exposición Dalí Lives de 2019 revivió digitalmente al pintor de Figueres mediante procesos de inteligencia artificial. Es un debate abierto y avivado, por ejemplo, por quienes propugnan la recreación digital de avatares interactivos de nuestros difuntos, para supuesto consuelo de quienes son incapaces de superar el duelo (algo que ya apuntó el episodio ‘Be Right Back’ de la conocida serie ‘Black Mirror’). Morboso, pero posible.

Las consecuencias de esta técnica en diferentes sectores profesionales resultan inimaginables. Por ejemplo, en el ámbito de la actuación cinematográfica o televisiva, ya hay quien augura que en el futuro próximo sólo habrá espacio para los intérpretes excepcionales, pues los actores de telefilm o los presentadores de telediario serán sustituidos por réplicas digitales que serán más baratas e indistinguibles de una persona de carne y hueso. Lo que ya es una realidad en el ámbito sonoro (gran parte de la música aparentemente analógica que escuchamos en realidad ha sido producida digitalmente), pronto se instalará definitivamente en el entorno visual. De hecho, es probable que cualquiera de nosotros pueda crear próximamente una película en su propia casa, con la única ayuda de un buen ordenador y un software adecuado, como hoy ya se componen bandas sonoras con un sintetizador.

Estos días se ha viralizado un mensaje que muestra estas nuevas posibilidades de forma muy ocurrente. El autor del vídeo comienza su disertación explicando ante la cámara cómo esta técnica permite generar una falsificación indetectable de una persona, y de pronto descubres que el rostro del individuo que habla no es real, sino una imagen generada artificialmente a partir del aspecto del verdadero creador del mensaje. Después de apuntar otras utilizades de estas nuevas tecnologías (como hacer que su avatar hable en diferentes idiomas o aclarar que algunas de sus frases son obra de un procesador de inteligencia artificial), el narrador concluye alertando sobre los riesgos que podrían derivarse de una utilización maliciosa de esta herramienta.

De hecho, la popularización del deepfake se produjo en 2017, cuando un usuario anónimo publicó en la plataforma Reddit varias secuencias pornográficas aparentemente protagonizadas por la actriz Daisy Ridley, conocida por su participación en la tercera trilogía de Star Wars. Para ello, el falsificador utilizó un verdadero vídeo erótico y sustituyó uno de los rostros por los de la intérprete británica. Poco tiempo después, también fue víctima de un deepfake pornográfico la actriz y modelo israelí Gal Gadot, demostrando los peligros de esta tecnología. Los políticos tampoco se han librado de la nueva técnica. En la mayoría de los casos, lo que se ha pretendido no ha sido confundir sino impactar (como en el vídeo de 2018 donde se falsificaba un discurso de Barack Obama precisamente para alertar sobre este problema) o provocar simple hilaridad (pensemos en la grabación de 2019 donde se sustituía la cara del comediante Jimmy Fallon por la de Donald Trump). Sin embargo, las posibilidades de distorsionar la opinión pública con declaraciones falsas parecen evidentes y deberíamos prepararnos para este reto. Sin ir más lejos, esta misma semana ha circulado por Facebook un deepfake de Zelensky rindiéndose ante Rusia.

En efecto, al margen de estos cambios disruptivos en algunas industrias, esta posibilidad tecnológica supone también una amenaza letal para la fiabilidad de la información que recibimos por medios audiovisuales no supervisados, una auténtica bomba de relojería en la era de las fakenews. Como me comentó hace un tiempo un buen amigo programador, quedan pocos años para que el vídeo de una rueda de prensa de un dirigente político, recibida por twitter o whatsapp, no signifique absolutamente nada, pues el ojo y el oído humanos serán incapaces de distinguir una declaración real y una creación artificial diseñada por un intoxicador.

Afortunadamente, comienza a abrirse camino un sector tecnológico que pretende dar respuesta a esta inquietud. Por ejemplo, la empresa ID R&D ofrece soluciones “Liveness detection”, que permiten identificar informáticamente una falsificación en vídeo que nuestros sentidos no percibirían a simple vista. Hasta ahora, este tipo de herramientas se están utilizando, por ejemplo, para evitar fraudes de identificación a nivel bancario. Sin embargo, sería deseable que estos filtros de alerta acabasen también implementados en los grandes canales de difusión informal, pues cada vez será más ingenuo fiarnos de lo que estamos viendo. Me viene a la cabeza una frase de ‘Sopa de ganso’: “¿A quién vas a creer, a mí o a tus propios ojos?” Una vez más, probablemente sin preverlo, Groucho volvió a acertar.

Comentarios

Publicar un comentario